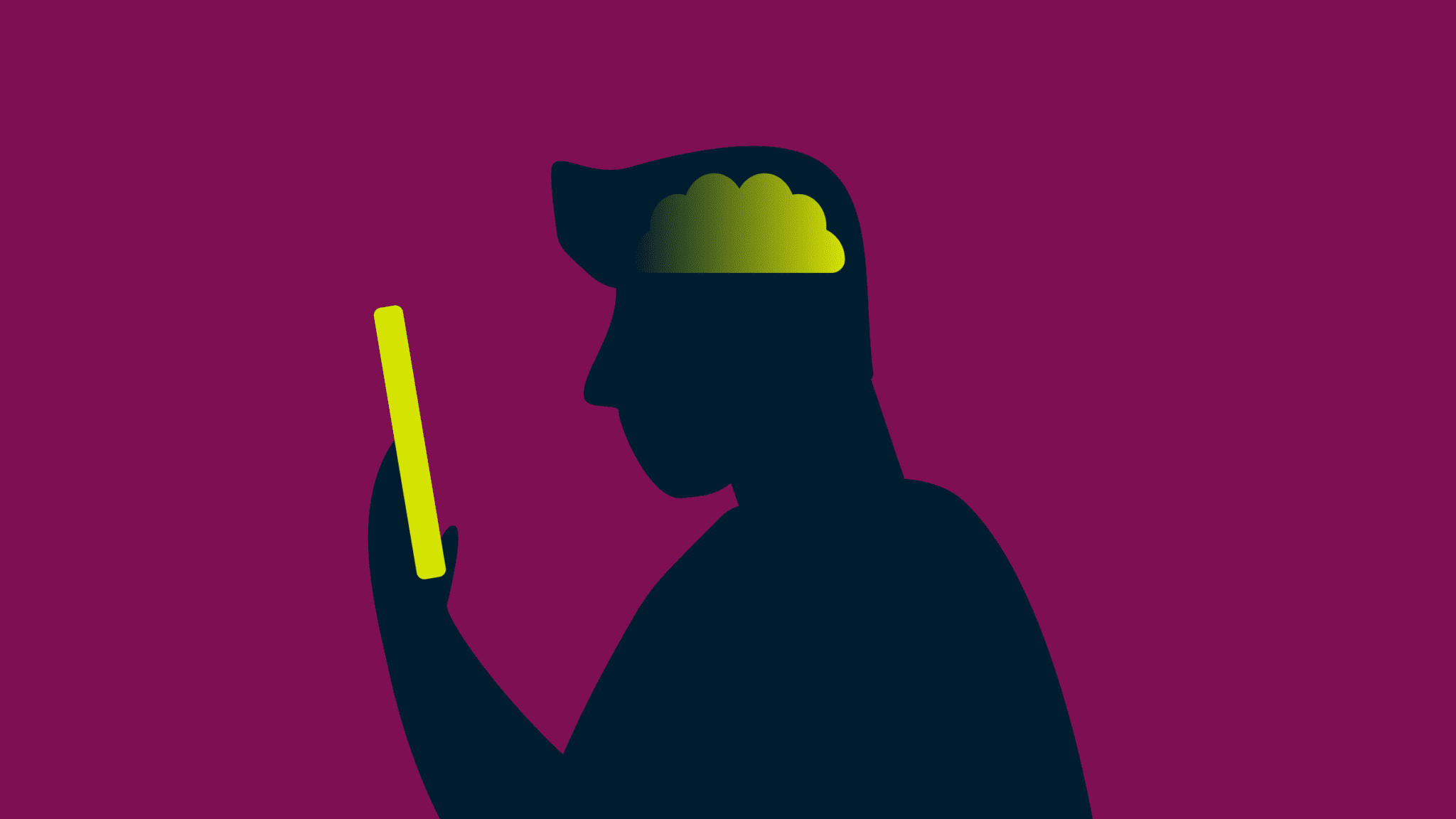

Comment les deepfakes affectent notre mémoire

Internet a été récemment bousculé par des images stupéfiantes ! Le pape en blouson et Vladimir Poutine à genoux embrassant la main de Xi Jinping. Que s'est-il passé ? Aucun de ces événements ne s'est réellement produit. Ce sont des deepfakes, le fruit d'une technologie d'intelligence artificielle avancée.

Ces montages basés sur le deep learning illustrent la facilité avec laquelle l'IA peut brouiller les frontières entre la réalité et la fiction, ce qui entraîne des conséquences extrêmement graves.

[Protégez votre activité en ligne et préservez votre confidentialité grâce à un VPN.]

Dans cette publication, nous examinons comment l'IA affecte notre mémoire et comment les deepfakes pourraient contribuer au phénomène connu sous le nom d’effet Mandela. Soyez prêts à remettre en question tout ce que vous pensiez savoir !

Qu'est-ce que l'effet Mandela ?

Ce terme fait référence à Nelson Mandela, révolutionnaire et homme politique sud-africain engagé dans la lutte contre l'apartheid. De nombreuses personnes ont cru qu'il était mort en prison dans les années 1980, alors qu'il existe de nombreuses preuves que ce n'est pas le cas. En réalité, il a été libéré en 1990, est devenu président de ce pays d'Afrique australe et est décédé en 2013.

L'effet Mandela a depuis été utilisé pour décrire plusieurs événements ou informations erronés, notamment l'orthographe de noms de marques, les paroles de chansons, l'intrigue de films ou de séries TV et diverses informations sur des faits historiques.

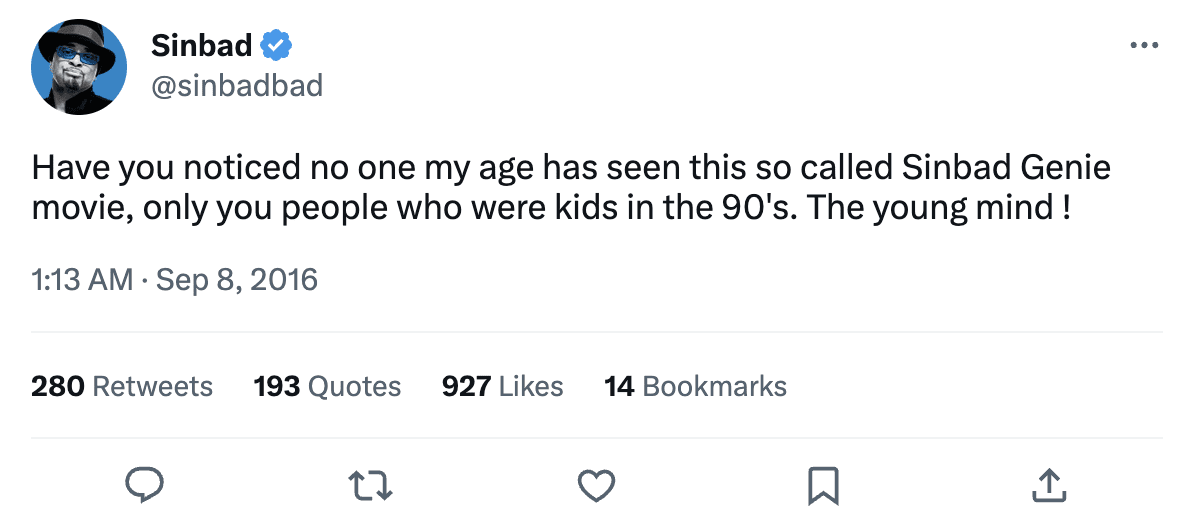

Le célèbre comédien des années 1990, Sinbad, est un exemple typique de l'effet Mandela. De nombreuses personnes affirment se souvenir d'un film intitulé Shazaam (à ne pas confondre avec le film de super-héros de 2019, Shazam !), dans lequel Sinbad joue le rôle d'un génie qui aide deux enfants. Cependant, ce film n'a jamais été réalisé. Le film qui s'en rapproche le plus est Kazaam, dans lequel Shaquille O'Neal incarne un génie.

Malgré l'absence de preuves attestant l'existence de Shazaam, de nombreuses personnes restent convaincues de l'avoir vu et se souviennent même de certains éléments de l'intrigue présumée, des personnages, et même de l'aspect de l'affiche du film. Même si Sinbad lui-même a confirmé qu'il n'avait jamais joué un génie, l'idée du film est tellement ancrée dans la mémoire de certains cinéphiles au point qu'ils sont tout à fait convaincus de son existence.

Quelles sont les causes de l'effet Mandela ?

Bien que les causes de l'effet Mandela ne soient pas entièrement définies par la science, plusieurs théories tendent à l'expliquer. L'une d'entre elles suggère qu'il s'agit d'un résultat de faux souvenirs, où des personnes se souviennent d'événements ou de faits altérés en raison d'une information erronée, d'une mauvaise interprétation ou du pouvoir de la suggestion. Une autre approche plus ambitieuse, suggère qu'il s'agit d'une faille dans la matrice ou d'un univers parallèle, où des personnes ont pu expérimenter une version différente de la réalité.

Les psychologues pensent que l'effet Mandela serait dû à la façon dont notre cerveau est structuré. Plus précisément, notre esprit peut parfois être influencé par ce que disent les autres ou par nos croyances préexistantes, ce qui peut nous amener à nous souvenir de faits erronés. Cela s'appelle un biais cognitif. Par exemple, si de nombreuses personnes sur les réseaux sociaux affirment que quelque chose s'est passé d'une certaine manière, cela peut nous amener à croire que cela s'est réellement passé de cette manière, même si ce n'est pas le cas.

Bien que l'effet Mandela ne date pas d'hier et qu'il renvoie principalement à la pop culture, l'essor des deepfakes implique une diffusion encore plus rapide et plus facile des fake news. De plus, davantage de personnes pourraient commencer à se souvenir de faits qui n'ont jamais eu lieu en réalité.

Cela soulève des questions importantes : pouvons-nous faire confiance aux informations que nous retrouvons en ligne, est-il acceptable d'utiliser l'IA pour manipuler des images et des vidéos, et quelle devrait être la portée de la technologie dans la formation de notre mémoire et de nos croyances ?

Le danger des souvenirs résultant de deepfakes

Les deepfakes exploitent l'IA pour créer des vidéos et des images réalistes de personnes disant ou faisant des choses qu'elles n'ont en réalité jamais dites ou faites. Cette technologie s'appuie sur le deep learning, une forme d'apprentissage automatique qui repose sur des réseaux neuronaux artificiels, capables de traiter de grandes quantités de données.

En 2019, moins de 15 000 deepfakes ont été identifiés en ligne. Aujourd'hui, ce nombre se chiffre en millions, et le nombre de deepfakes conçus par des experts continue d'augmenter à un rythme annuel de 900 % selon le Forum économique mondial.

L'un des enjeux majeurs des deepfakes est qu'ils peuvent être utilisés à des fins malveillantes, comme la diffusion de fake news, la propagande, ou l'usurpation d'identité dans le but d'en tirer un profit financier. La technologie est également utilisée pour créer de faux contenus pornographiques, ce qui suscite des inquiétudes quant aux risques d'exploitation humaine et d'abus.

Les deepfakes ont le pouvoir de faire croire aux gens qu'ils ont vu quelque chose qui ne s'est jamais produit, compte tenu de la grande précision des technologies utilisées. Cela peut les amener à se souvenir à tort d'un événement fictif comme s'il s'agissait d'un fait réel.

Voici quelques exemples de la manière dont les deepfakes peuvent contribuer à l'effet Mandela, et les dangers potentiels qui en découlent :

Diffuser des fake news

Les deepfakes pourraient être utilisés pour créer des fake news si réalistes que les gens finissent par les croire, même si elles sont complètement falsifiées. Par exemple, des attaques terroristes ou des catastrophes naturelles créées dans le seul but de faire avancer certains objectifs socio-politiques. Si ces histoires sont le résultat de deepfakes, elles peuvent ressembler à de véritables reportages, avec des séquences vidéo et audio convaincantes. Cela pourrait en fin de compte fausser la perception des événements historiques pour les générations futures.

Influencer l'opinion politique

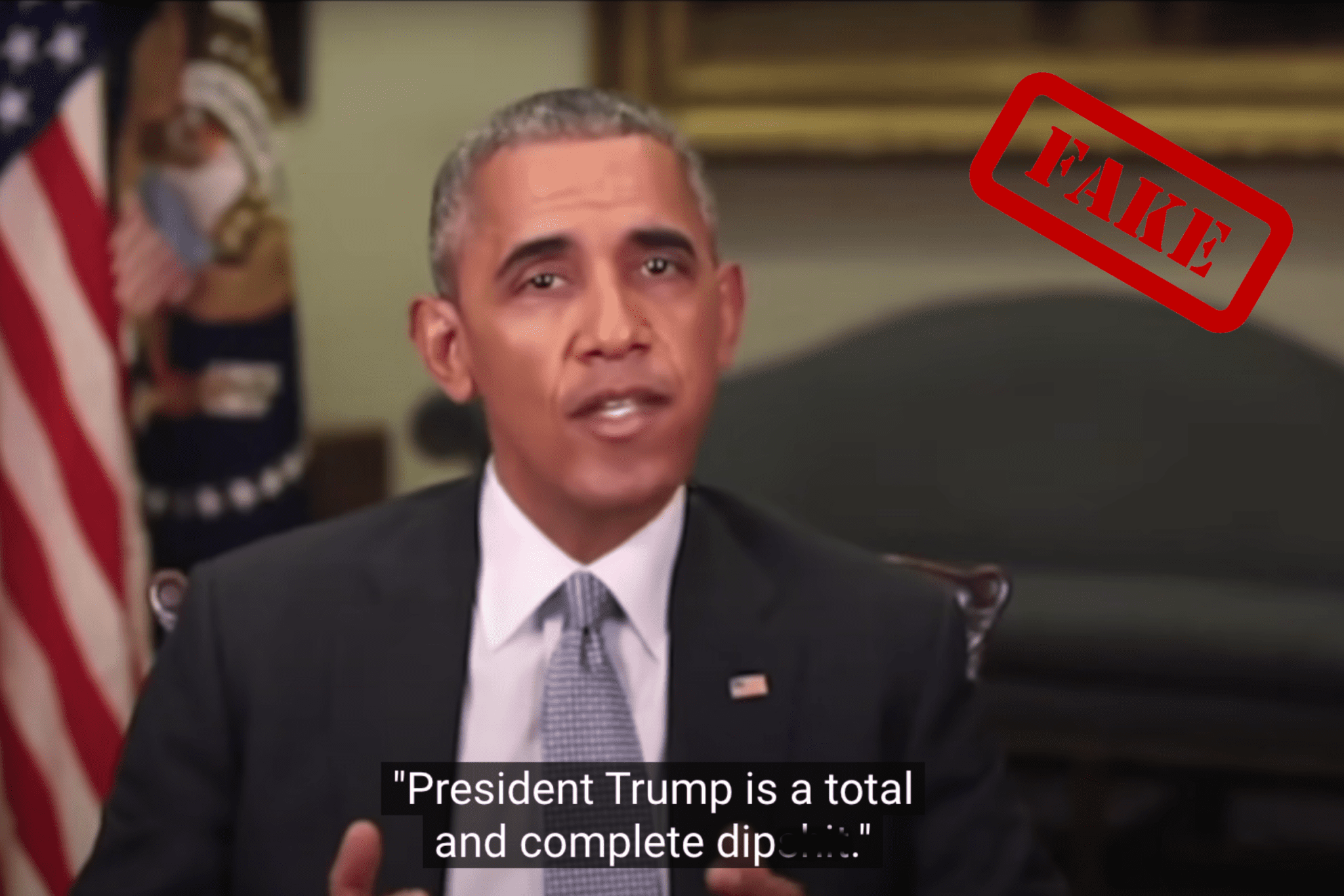

Quelques mois avant les élections de mi-mandat en 2018, un deepfake de Barack Obama traitant le président de l'époque, Donald Trump, de tous les maux est devenue virale. Créée par le réalisateur oscarisé Jordan Peele, cette vidéo visait à sensibiliser les internautes à la nécessité de vérifier les informations qu'ils trouvent en ligne. Ironiquement, la vidéo s'est retournée contre les partisans de Donald Trump qui l'ont crue réelle, et des hordes d'entre eux se sont rendues sur les réseaux sociaux pour exprimer leur indignation.

Si une vidéo deepfake similaire d'un candidat politique ou d'une personnalité publique disant ou faisant quelque chose qui ne s'est jamais produit était suffisamment convaincante, on pourrait alors assister à des atteintes au fonctionnement de la démocratie et à la méfiance des citoyens à l'égard des institutions.

Par exemple, si de plus en plus de personnes sont exposées à une vidéo deepfake potentiellement convaincante, mettant en scène des candidats politiques de leur pays sur les réseaux sociaux ou par l'intermédiaire de divers organes d'information, de faux souvenirs pourraient se répandre et être considérés comme authentiques. Cela peut influencer le choix des citoyens lors des élections pour la désignation de leurs dirigeants.

Mener des campagnes de propagande

Les campagnes de propagande créées à l'aide de deepfakes peuvent être utilisées pour manipuler l'opinion publique et répandre la désinformation via des groupes qui soutiennent les régimes en place, ce qui aboutit à une vision biaisée de la réalité. Par exemple, dans le cadre du conflit en cours avec la Russie, les services de renseignement ukrainiens ont récemment signalé un deepfake du président ukrainien Volodymyr Zelenskyy, dans lequel on le voit appeler les Ukrainiens à se rendre.

Bien que de nombreuses plateformes aient supprimé la vidéo, elle continue à être diffusée sur plusieurs sites de réseaux sociaux tels que Facebook, Reddit et TikTok, semant la discorde et les critiques parmi les internautes.

Falsifier les faits historiques

Les deepfakes pourraient être utilisés pour diffuser des séquences historiques corrompues, notamment des discours politiques ou des événements importants. Une telle manipulation pourrait modifier la mémoire du public cible quant aux événements qui se sont réellement déroulés. La confusion et l'incertitude sur le passé d'un pays seraient alors généralisées, érodant la confiance des citoyens vis-à-vis des archives historiques et des médias, d'où l'émergence des théories conspirationnistes.

Prenons l'exemple de l'alunissage. Aujourd'hui encore, certains prétendent qu'il s'agit d'un simulacre et qu'il n'a jamais eu lieu. Les deepfakes pourraient être utilisés pour reproduire des vidéos et des enregistrements audio convaincants qui étayent ce faux récit, renforçant ainsi le scepticisme et la méfiance sur l'authenticité de cet événement historique.

Propager de fausses informations en ligne

Avec la facilité d'accès aux plateformes de réseaux sociaux, les deepfakes peuvent être utilisés pour créer de faux messages qui donnent l'impression que des célébrités, des personnalités publiques ou des influenceurs sont présents à un événement ou soutiennent un produit particulier, alors qu'en réalité ce n'est pas le cas. En propageant de fausses idées librement, les deepfakes peuvent polariser davantage la société et créer un terreau fertile pour des campagnes de désinformation. Cela nuit à la crédibilité des réseaux sociaux en tant qu'outil de communication, pourtant essentiel à la démocratie et à la cohésion sociale.

Réfuter les preuves scientifiques

Des origines d'un virus aux percées de la médecine, les deepfakes peuvent être utilisés pour créer de fausses preuves scientifiques afin d'étayer une affirmation ou une hypothèse non fondées. Par exemple, certaines personnes tentent de diffuser de fausses informations sur le changement climatique, même s’il est scientifiquement prouvé qu'il est dû à l'activité humaine. Cela constitue une entrave aux initiatives visant à trouver des solutions aux problèmes majeurs comme le réchauffement de la planète.

Les deepfakes peuvent répandre de fausses preuves scientifiques affirmant que le changement climatique est causé par des facteurs naturels, ce qui peut avoir de graves conséquences. Les décideurs politiques pourraient être moins enclins à prendre des mesures pour lutter contre ce phénomène s'il existe un scepticisme généralisé quant à ses causes. Cela pourrait diviser davantage l'opinion publique et rendre plus difficile la recherche d'un consensus sur la manière de traiter ce problème urgent.

Créer de faux alibis

Enfin, les deepfakes pourraient également être utilisés pour créer de faux aveux ou de fausses déclarations dans le cadre d'affaires judiciaires, ou pour manipuler des images de sécurité afin de créer des alibis pour les criminels. Cela pourrait conduire à la diffusion de faux témoignages sur des actes criminels : les gens croyant a) que l'auteur n'a pas commis le crime ou b) qu'une personne innocente a commis le crime. Avec le temps, un faux raisonnement peut s'ancrer dans la mémoire des protagonistes pour croire qu'il s'agit d'un fait avéré.

Supposons qu'il s'agisse d'une affaire criminelle très médiatisée dans laquelle les avocats de défense crée une fausse vidéo très réaliste montrant l'accusé dans un lieu différent au moment du crime. La vidéo est largement diffusée et de nombreuses personnes en viennent à penser que l'accusé n'a pas pu commettre le meurtre. Même s'il est prouvé par la suite que la vidéo est un deepfake et que l'accusé est reconnu coupable, certaines personnes peuvent continuer à croire que l'accusé était innocent à cause de la vidéo.

10 astuces pour identifier un deepfake

Afin de lutter contre le problème des deepfakes qui créent de faux souvenirs, il est essentiel que nous restions tous critiques et sceptiques à l'égard des informations que nous consommons. Les entreprises technologiques et les gouvernements collaborent pour mettre au point des solutions permettant de détecter et d'empêcher la diffusion des deepfakes.

En attendant, découvrez comment repérer un deepfake :

- Distorsions et transformations faciales

- Recherchez les distorsions d'éclairage et de conversion 3D sur le visage.

- Vérifiez les incohérences de texture, en particulier au niveau des joues, du front, des sourcils et des poils du visage.

- Mouvements réalistes des yeux et des lèvres

- Vérifiez si les ombres, la couleur et le clignement des yeux, ainsi que les mouvements des grains de beauté sont réalistes.

- Vérifiez si les lèvres du sujet ont l'air naturelles et appartiennent au personnage.

- Mouvements et gestes du personnage

- Prêtez attention aux mouvements et aux gestes du sujet dans la vidéo.

- Notez s'ils semblent maladroits ou imparfaits.

- Analyse audio

- Écoutez attentivement le son de la vidéo.

- Vérifiez si la voix semble artificielle ou si elle présente des anomalies, car il est possible qu'elle soit générée par l'intelligence artificielle ou qu'elle ait été modifiée.

- Incohérences dans l'éclairage et les reflets

- Recherchez les incohérences dans l'éclairage et les reflets qui peuvent être incompatibles avec l'environnement ou la position du personnage dans la vidéo ou l'image.

- Contenu de la vidéo

- Trouvez la vidéo originale ou recherchez d'autres exemples pour vérifier le contenu.

- Utilisez la recherche inversée d'images avec des outils tels que Google Image Search, TinEye, SauceNAO ou Bing Visual Search.

- Analyse contextuelle

- Évaluez le contexte dans lequel la vidéo a été postée ou partagée, car il peut indiquer si elle est authentique ou non (par exemple, pourquoi le pape changerait-il soudainement la tenue habituelle portée dans le palais du Vatican ?)

- Vérifiez la source originale de la vidéo, s'il s'agit d'un organe de presse réputé, d'une personne sur les réseaux sociaux ou d'un individu aux intentions douteuses.

- Situations anormales ou inhabituelles

- Méfiez-vous des vidéos montrant des situations improbables, telles qu'une personne célèbre faisant quelque chose d'inhabituel ou une personnalité politique tenant des propos controversés.

- Métadonnées

- Vérifiez les métadonnées de la vidéo pour voir si elles correspondent aux affirmations faites, telles que l'heure et le lieu de l'enregistrement.

- Gardez à l'esprit que les métadonnées peuvent être facilement modifiées et qu'elles ne doivent donc pas être la seule base pour déterminer l'authenticité d'une vidéo.

- Actualité

- Sachez que la technologie utilisée pour créer des deepfakes s'améliore constamment et qu'il pourrait devenir plus difficile de les repérer dans le futur.

- Veuillez suivre l'actualité et soyez prudent lorsque vous partagez ou réagissez à des vidéos qui semblent suspectes et qui doivent être signalées.

Prenez les premières mesures pour assurer votre sécurité en ligne. Essayez ExpressVPN sans courir le moindre risque.

Obtenez ExpressVPN