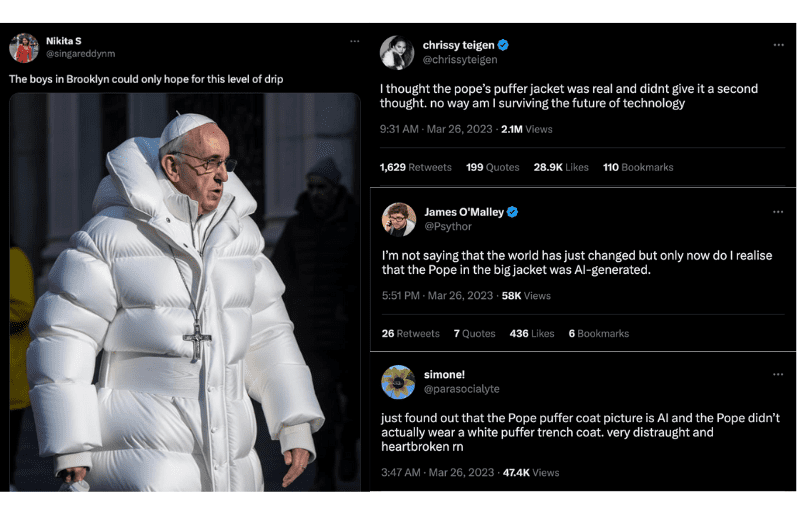

Het internet wordt de laatste tijd opgeschrikt door verbijsterende beelden. De paus in een donsjas en Vladimir Poetin op de knieën voor een kus op de hand van Xi Jinping. Het addertje onder het gras? Geen van deze gebeurtenissen zijn waargebeurd. Ze zijn het product van geavanceerde AI-technologie, bekend als deepfakes.

Deze op deep learning gebaseerde vervalsingen laten zien hoe gemakkelijk AI de grenzen tussen werkelijkheid en fictie kan doen vervagen, met aanzienlijke en verstrekkende gevolgen.

[Houd je online activiteit veilig en je persoonlijke informatie privé met een VPN.]

We onderzoeken hoe AI de manier waarop we ons herinneren verandert en hoe deepfakes mogelijk kunnen bijdragen aan het fenomeen dat bekendstaat als het Mandela-effect. Maak je klaar om alles wat je dacht te weten in twijfel te trekken.

Wat is het Mandela-effect?

Deze term is genoemd naar Nelson Mandela, anti-apartheidsrevolutionair en voormalig president van Zuid-Afrika. Veel mensen geloofden dat hij in de jaren tachtig in de gevangenis was gestorven, ondanks overvloedig bewijs dat dit niet zo was. In werkelijkheid werd hij in 1990 vrijgelaten, werd president en overleed uiteindelijk in 2013.

Het Mandela-effect wordt sindsdien gebruikt om een verscheidenheid aan collectief verkeerd herinnerde gebeurtenissen of details te beschrijven, waaronder de spelling van merknamen, de tekst van liedjes, de plot van films of tv-programma's en de details van historische gebeurtenissen.

Een voorbeeld van het Mandela-effect in actie betreft de Bijlmerramp die op 4 oktober 1992 plaatsvond in Amsterdam. Veel mensen beweren zich de beelden te herinneren waarop de Boeing 747 van de Israëlische luchtvaartmaatschappij El Al te zien was zoals die op de flats in de Bijlmermeer was neergestort. Zulke beelden hebben echter nooit bestaan. Het dichtste bij zijn foto’s van de nasleep van de ramp – zonder vliegtuig.

Desondanks, blijven veel mensen ervan overtuigd dat ze de beelden gezien hebben en herinneren ze zich details over bijvoorbeeld de hoek waarin het vliegtuig zich door de flatgebouwen boorde. En dan is er nog het mysterie van de mannen in witte pakken die veelvuldig op het terrein werden gesignaleerd en ondanks het gebrek aan bewijs in het geheugen gegrift blijven van ooggetuigen.

[QUIZ] Houdt je geheugen je voor de gek? Test je kennis met onze Mandela-effect quiz:

[evpn_typeform id="QTr1CMrm"]

Wat veroorzaakt het Mandela-effect?

Hoewel de oorzaak van het Mandela-effect niet volledig bekend is, zijn er verschillende theorieën die het pogen te verklaren. Een daarvan stelt dat het een gevolg is van valse herinneringen, waarbij mensen zich gebeurtenissen of feiten verkeerd herinneren door verkeerde informatie of interpretatie, of de kracht van suggestie. Een andere, verdergaande theorie is dat het komt door een hapering in de matrix of een parallel universum, waar mensen een andere versie van de werkelijkheid ervaren.

Psychologen denken dat het Mandela-effect veroorzaakt kan worden door de manier waarop onze hersenen bedraad zijn. In andere woorden, de manier waarop onze geest soms beïnvloed kan worden door dingen zoals wat andere mensen zeggen of door onze eigen reeds bestaande overtuigingen, waardoor we ons zaken verkeerd kunnen herinneren. Dit wordt cognitieve bias genoemd. Als veel mensen bijvoorbeeld op sociale media zeggen dat iets op een bepaalde manier is gebeurd, kan dat ons doen geloven dat het echt zo is gebeurd, zelfs als dat niet zo is.

Hoewel het Mandela-effect niet recent is en vooral betrekking heeft op de popcultuur, betekent de opkomst van deepfakes dat valse informatie zich nog sneller en gemakkelijker kan verspreiden, en dat meer mensen zich dingen gaan herinneren die nooit echt gebeurd zijn.

Dit roept belangrijke vragen op over de betrouwbaarheid van de informatie die we online zien, het gebruik van AI om beelden en video's te manipuleren en hoeveel macht technologie zou moeten hebben bij het vormen van onze herinneringen en overtuigingen.

Het gevaar van herinneringen afgeleid van deepfakes

Deepfakes gebruiken AI om realistisch ogende video's en beelden te maken van mensen die dingen zeggen en doen die ze in werkelijkheid nooit hebben gezegd of gedaan. De technologie is gebaseerd op deep learning, een soort machinaal leren waarbij kunstmatige neurale netwerken worden getraind aan de hand van grote hoeveelheden gegevens.

In 2019 waren er minder dan 15.000 deepfakes online gedetecteerd. Vandaag de dag loopt dat aantal in de miljoenen, waarbij het aantal door experts gemaakte deepfakes jaarlijks met 900% blijft toenemen, volgens het World Economic Forum.

Een van de meest verontrustende aspecten van deepfakes is dat ze kunnen worden gebruikt voor kwaadaardige doeleinden, zoals het creëren van nepnieuws of propaganda, of het zich voordoen als iemand voor financieel gewin. De technologie wordt ook gebruikt om deepfake-porno te maken, wat aanleiding geeft tot bezorgdheid over de uitbuiting van personen en de mogelijkheid van misbruik.

Door de zeer realistische aard van de technologie kunnen deepfakes mensen ook doen geloven dat zij iets hebben gezien dat nooit echt is gebeurd. Dit kan er uiteindelijk toe leiden dat zij zich een onwaar scenario verkeerd herinneren als feit.

Hier volgen enkele voorbeelden van hoe deepfakes kunnen bijdragen tot het Mandela-effect, en de gevaren die daarmee gepaard gaan:

Het creëren van nepnieuwsverhalen

Deepfakes kunnen worden gebruikt om valse nieuwsberichten te creëren die zo realistisch zijn dat mensen geloven dat ze waar zijn, zelfs als ze volledig verzonnen zijn, bijvoorbeeld valse nieuwsberichten zoals terroristische aanslagen of natuurrampen die zijn gecreëerd met als enig doel bepaalde sociaal-politieke agenda's aan te jagen. Als deze verhalen worden gemaakt met deepfakes, kunnen ze eruit zien als echte nieuwsberichten, compleet met overtuigende video- en audiobeelden. Dit kan uiteindelijk leiden tot een vertekend beeld van de geschiedenis en de gebeurtenissen voor de komende generaties.

De politieke opinie beïnvloeden

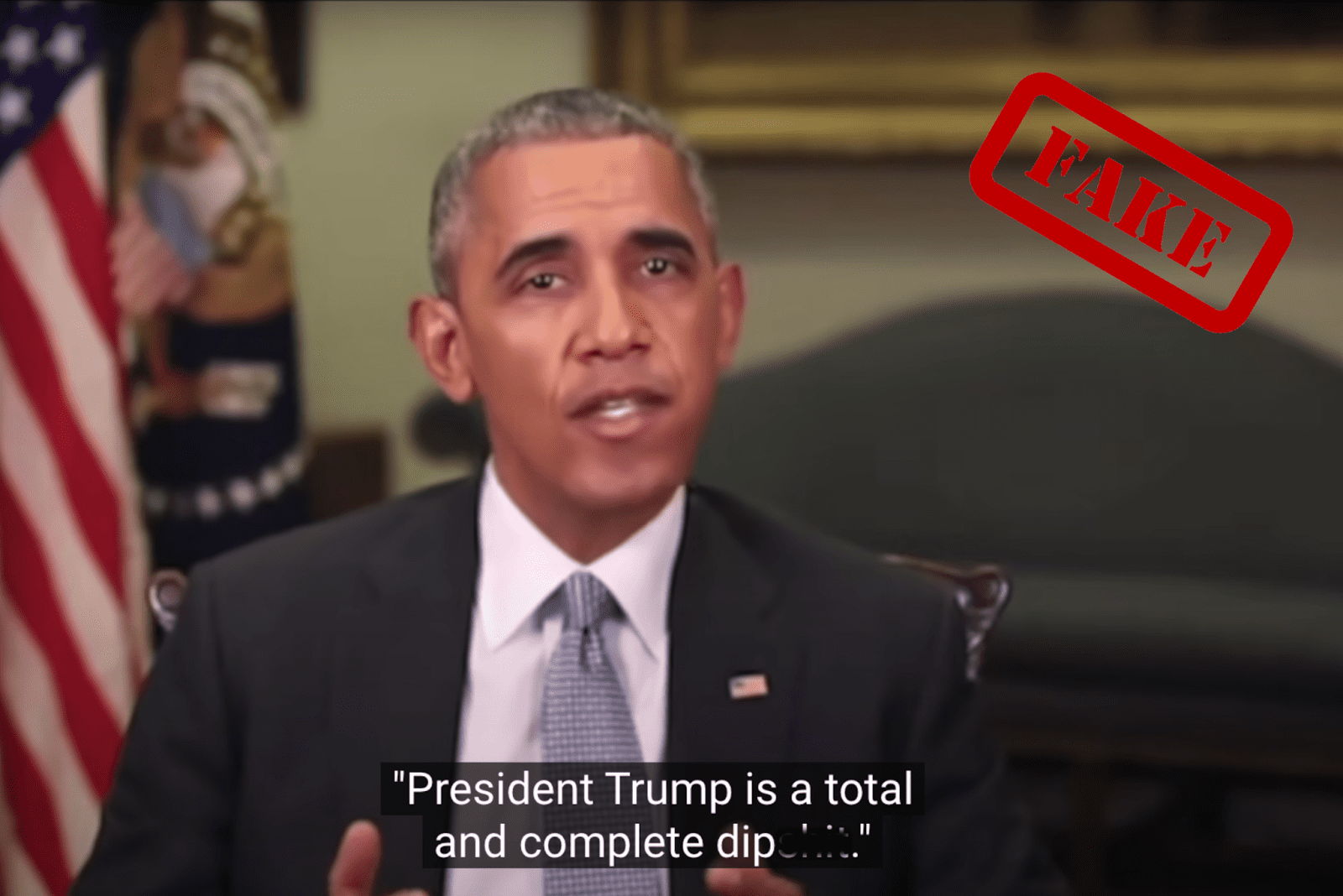

Een paar maanden voor de tussentijdse verkiezingen van 2018 ging een deepfake-video van Barack Obama die toenmalig president Donald Trump een slechte naam gaf, viraal. De video werd gemaakt door de Oscarwinnende regisseur Jordan Peele om gebruikers te waarschuwen voor het vertrouwen in het materiaal dat ze online tegenkomen. Ironisch genoeg werkte de video averechts nadat veel aanhangers van Trump geloofden dat hij echt was, en hordes van hen gingen naar de sociale media om hun verontwaardiging te uiten.

Als een soortgelijke deepfake-video van een politieke kandidaat of een publiek figuur die iets zegt of doet dat nooit echt gebeurd is, overtuigend genoeg is, kan dat schadelijke gevolgen hebben voor het functioneren van de democratie en het vertrouwen dat mensen in instellingen hebben.

Als bijvoorbeeld meer en meer mensen op sociale media of via verschillende nieuwskanalen worden blootgesteld aan een potentieel overtuigende deepfake-video van de politieke kandidaten van hun land, kunnen valse herinneringen zich verspreiden en als waarheid worden aanvaard. Dit kan van invloed zijn op wie mensen bij verkiezingen stemmen en wie zij tot hun leiders benoemen.

Aansturen van propagandacampagnes

Propagandacampagnes met deepfakes kunnen worden gebruikt om de publieke opinie te manipuleren en desinformatie over door de staat gesteunde groepen te verspreiden — wat uiteindelijk leidt tot een vertekend beeld van de werkelijkheid. In verband met het lopende conflict met Rusland heeft de Oekraïense inlichtingendienst bijvoorbeeld onlangs gewaarschuwd dat er een deepfake van de Oekraïense president Volodymyr Zelensky in omloop was, waarin hij de Oekraïners oproept zich over te geven.

Ondanks het feit dat veel platforms de video hebben verwijderd, blijft hij opduiken op verschillende sociale mediasites zoals Facebook, Reddit en TikTok — om verdeeldheid te zaaien onder het publiek en het moeilijker te maken de waarheid te achterhalen.

Wijziging van historische beelden

Deepfakes zouden kunnen worden gebruikt om historische beelden, zoals beelden van politieke toespraken of belangrijke gebeurtenissen, zodanig te veranderen dat mensen zich niet meer kunnen herinneren wat er werkelijk is gebeurd. Dit kan leiden tot verwarring en onzekerheid over wat er in het verleden echt is gebeurd, waardoor het vertrouwen van het publiek in historische documenten en media wordt aangetast — wat uiteindelijk samenzweringstheorieën in de hand werkt.

Neem bijvoorbeeld de maanlanding. Tot op de dag van vandaag beweren sommige mensen dat die nep was en nooit echt heeft plaatsgevonden. Deepfakes zouden kunnen worden gebruikt om overtuigende video's en geluidsopnamen te maken die dit valse verhaal ondersteunen, waardoor het scepticisme en wantrouwen in de authenticiteit van de historische gebeurtenis wordt versterkt.

Manipuleren van sociale media-content

Door de gemakkelijke toegang tot sociale mediaplatforms kunnen deepfakes worden gebruikt om valse berichten te maken waardoor het lijkt alsof beroemdheden, publieke figuren of beïnvloeders aanwezig zijn bij een evenement of een bepaald product aanprijzen, terwijl ze dat in werkelijkheid niet zijn of doen. Doordat valse verhalen zich ongecontroleerd kunnen verspreiden, kunnen deepfakes de samenleving verder polariseren en een vruchtbare bodem creëren voor desinformatiecampagnes. Dit ondermijnt op zijn beurt de geloofwaardigheid van sociale media als communicatiemiddel, wat cruciaal is voor de democratie en sociale cohesie.

Het fabriceren van wetenschappelijk bewijs

Van de oorsprong van een virus tot medische doorbraken, deepfakes kunnen worden gebruikt om vals wetenschappelijk bewijs te creëren ter ondersteuning van een onware bewering of hypothese. Sommige mensen proberen bijvoorbeeld desinformatie te verspreiden over klimaatverandering, ondanks het overweldigende wetenschappelijke bewijs dat die wordt veroorzaakt door menselijke activiteit. Dit vormt een bedreiging voor belangrijke zaken als de opwarming van de aarde.

Deepfakes kunnen vals wetenschappelijk bewijs creëren dat beweert dat klimaatverandering wordt veroorzaakt door externe factoren, wat ernstige gevolgen kan hebben; beleidsmakers zullen wellicht minder snel actie ondernemen om klimaatverandering aan te pakken als er een wijdverbreid scepticisme bestaat over de oorzaken ervan. Dit kan de publieke opinie verder verdelen en het moeilijker maken om een consensus te bereiken over de aanpak van dit dringende probleem.

Het creëren van valse alibi's

Daarnaast kunnen deepfakes ook worden gebruikt om valse bekentenissen of verklaringen in rechtszaken te creëren of om beveiligingsbeelden te manipuleren om alibi's voor criminelen te creëren. Dit kan leiden tot valse verhalen rond de gebeurtenissen van het misdrijf, waarbij mensen geloven a) dat de dader het misdrijf niet heeft gepleegd of b) dat een onschuldig persoon het heeft gedaan. Na verloop van tijd kan dit valse verhaal ingebakken raken in het collectieve geheugen van degenen die bij de zaak betrokken zijn en doen geloven dat het een feit is.

Stel je eens voor dat er een belangrijke strafzaak is waarbij het verdedigingsteam een zeer realistische deepfake-video maakt waarop de verdachte op een andere locatie te zien is ten tijde van het misdrijf. De video wordt op veel plekken verspreid en veel mensen gaan geloven dat de verdachte de moord niet kan hebben gepleegd. Zelfs als later wordt bewezen dat de video een deepfake is en de verdachte schuldig wordt bevonden, kunnen sommige mensen door hun herinnering aan de video blijven geloven dat de verdachte onschuldig was.

10 manieren om een deepfake te herkennen

In de wijze woorden van Abraham Lincoln: "Vertrouw nooit iets wat je op internet ziet." Om het probleem van deepfakes die valse herinneringen creëren te bestrijden, is het essentieel dat we allemaal kritisch en sceptisch blijven over de informatie die we consumeren, en dat technologiebedrijven en overheden samenwerken om oplossingen te ontwikkelen om de verspreiding van deepfake-video's op te sporen en te voorkomen.

Leer alvast hoe je een deepfake kunt herkennen om jezelf te beschermen tegen de verspreiding van desinformatie en valse herinneringen:

- Gezichtsvervormingen en -transformaties

- Zoek naar vervormingen in het gezicht door belichting en 3D-conversie.

- Controleer op inconsistenties in textuur, vooral in wangen, voorhoofd, wenkbrauwen en gezichtshaar.

- Realistische oog- en lipbewegingen

- Ga na of de schaduwen, oogkleur, moedervlekken tijdens bewegingen en knipperen er realistisch uitzien.

- Controleer of de lippen van de persoon er natuurlijk uitzien en bij dat gezicht horen.

- Bewegingen en gebaren van de persoon

- Let op de bewegingen en gebaren van de persoon in de video.

- Let op of ze onhandig of té perfect lijken.

- Audio-analyse

- Luister goed naar de audio in de video.

- Controleer of de stem kunstmatig klinkt of vervormingen vertoont, want mogelijk worden AI-gegenereerde of gewijzigde stemmen gebruikt.

- Inconsistenties in verlichting en reflecties

- Zoek naar inconsistenties in verlichting en reflecties die mogelijk niet overeenkomen met de omgeving of de positie van de persoon in de video of afbeelding.

- Controleer de inhoud van de video

- Zoek de originele video of naar andere voorbeelden ervan om de inhoud te verifiëren.

- Gebruik het omgekeerd zoeken naar een afbeelding met tools zoals Google Image Search, TinEye, SauceNAO of Bing Visual Search.

- Contextuele analyse

- Evalueer de context waarin de video is geplaatst of gedeeld, omdat deze kan aangeven of de video echt is of niet (waarom zou de paus bijvoorbeeld plotseling afwijken van de typische regalia die vaak worden gedragen in de pauselijke huishouding).

- Controleer de oorspronkelijke bron van de video, of het nu een gerenommeerde nieuwsorganisatie is, een willekeurig persoon op sociale media of een individu met een twijfelachtige agenda.

- Onnatuurlijke of ongewone situaties

- Wees sceptisch over video's die ongewone of onwaarschijnlijke situaties laten zien, zoals een beroemd persoon die iets doet wat niet bij zijn karakter past of een politiek figuur die iets controversieels zegt.

- Controleer metadata

- Controleer de metadata van de video om te zien of deze overeenkomen met de beweringen in de video, zoals de tijd en plaats van de opname.

- Houd er rekening mee dat metadata gemakkelijk kunnen worden gewijzigd, dus het mag niet de enige basis zijn om de authenticiteit van een video te bepalen.

- Blijf up-to-date

- Wees je ervan bewust dat de technologie die wordt gebruikt om deepfakes te maken voortdurend wordt verbeterd en dat het in de toekomst moeilijker kan worden om ze te herkennen.

- Blijf zo goed mogelijk op de hoogte van nieuwe ontwikkelingen op dit gebied en wees voorzichtig met het delen van of reageren op video's die verdacht of extreem nieuwswaardig lijken.

Take the first step to protect yourself online. Try ExpressVPN risk-free.

Get ExpressVPN