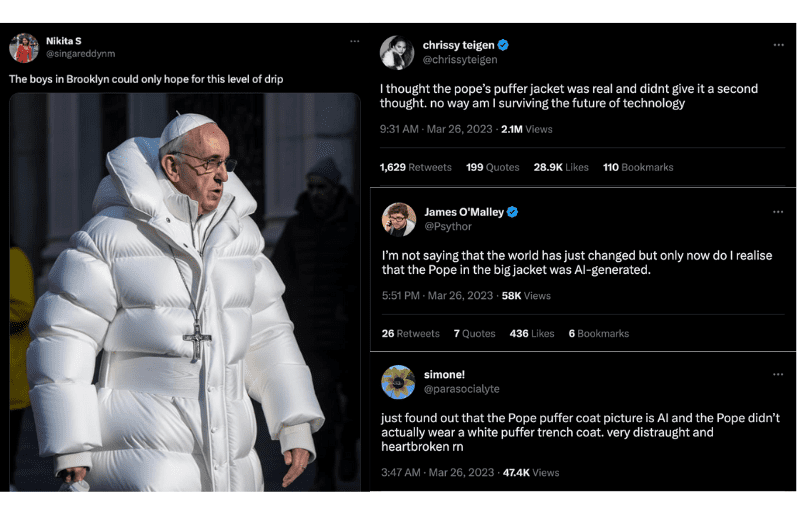

Internetem wstrząsają ostatnio zadziwiające obrazy. Papież w puchowej kurtce i Władimir Putin na klęczkach całujący rękę Xi Jinpinga. Prawda jest taka, że żadne z tych wydarzeń nie miało miejsca. Są one wytworem zaawansowanej technologii AI znanej jako deepfakes.

Wspomniane deepfakes pokazują, jak łatwo AI może zatrzeć granice między rzeczywistością a fikcją – z istotnymi i daleko idącymi implikacjami.

[Zabezpiecz swoją aktywność online i chroń prywatność danych dzięki wersji próbnej VPN].

Przyjrzymy się temu, jak AI zmienia sposób, w jaki zapamiętujemy różne rzeczy i jak deepfakes mogą potencjalnie przyczynić się do zjawiska znanego jako Efekt Mandeli. Przygotuj się na kwestionowanie... wszystkiego.

Czym jest Efekt Mandeli?

Termin ten został nazwany na cześć Nelsona Mandeli, południowoafrykańskiego rewolucjonisty i polityka walczącego z apartheidem. Wielu ludzi wierzyło, że zmarł w więzieniu w latach 80-tych, pomimo licznych dowodów, że tak nie było. W rzeczywistości został wypuszczony w 1990 roku, został prezydentem południowoafrykańskiego kraju i ostatecznie zmarł w 2013 roku.

Efekt Mandeli był od tego czasu używany do opisywania różnych błędnie zapamiętanych wydarzeń lub szczegółów, w tym pisowni nazw marek, tekstów piosenek, fabuły filmów lub programów telewizyjnych, a także szczegółów wydarzeń historycznych.

Jednym z przykładów Efektu Mandeli jest popularny w latach 90. komik Sinbad. Wiele osób twierdzi, że pamięta film o nazwie Shazaam (nie mylić z filmem o superbohaterach z 2019 roku: Shazam!), gdzie Sinbad gra dżina, który pomaga dwójce dzieci. Jednak żaden taki film nigdy nie powstał. Najbliżej prawdy jest film o nazwie Kazaam, w którym w roli dżina wystąpił Shaquille O'Neal.

Pomimo braku dowodów na to, że Shazaam istnieje, wiele osób nadal twierdzi, że go widziało i pamięta szczegóły dotyczące fabuły, postaci, a nawet tego, jak wyglądał plakat filmowy. Nawet jeśli sam Sinbad powiedział, że nigdy nie grał dżina, fikcyjny film już na zawsze został zakorzeniony w ludzkiej pamięci.

[evpn_typeform id="MFW1dHDk"]

Co powoduje Efekt Mandeli?

Chociaż przyczyna Efektu Mandeli nie jest w pełni zrozumiała, istnieje kilka teorii, które próbują wyjaśnić to zjawisko. Jedna z nich sugeruje, że jest to wynik fałszywych wspomnień, tj. ludzie pamiętają wydarzenia lub fakty w sposób nieprawidłowy z powodu błędnych informacji, błędnej interpretacji lub siły sugestii. Inna, bardziej dalekosiężna teoria mówi o tym, że jest to spowodowane usterką w matrycy lub równoległym wszechświecie, gdzie ludzie mogli doświadczyć innej wersji rzeczywistości.

Psychologowie uważają, że Efekt Mandeli może być spowodowany konstrukcją naszych mózgów - nasze umysły łatwo ulegają wpływom. To, co mówią inni ludzie lub nasze własne wcześniejsze przekonania może prowadzić do zapamiętania rzeczy w sposób nieprawidłowy. Nazywa się to tendencyjnością poznawczą. Na przykład, jeśli wiele osób w mediach społecznościowych twierdzi, że coś wydarzyło się w określony sposób, może to sprawić, że uwierzymy, że naprawdę tak się stało, nawet jeśli w ogóle nie miało to miejsca.

Chociaż Efekt Mandeli nie jest zjawiskiem nowym i dotyczy głównie popkultury, powstanie deepfake'ów oznacza, że fałszywe informacje mogą rozprzestrzeniać się jeszcze szybciej i łatwiej, a w efekcie coraz więcej osób może zacząć pamiętać rzeczy, które w rzeczywistości nigdy się nie wydarzyły.

To rodzi kilka ważnych pytań: czy możemy ufać informacjom, które widzimy w sieci? Czy w porządku jest używanie sztucznej inteligencji do manipulowania obrazami i filmami? A także, jak duży wpływ powinna mieć technologia w kwestii kształtowania naszych wspomnień i przekonań?

Niebezpieczeństwo związane z deepfake'owymi wspomnieniami

Deepfakes wykorzystują sztuczną inteligencję do tworzenia realistycznie wyglądających filmów i obrazów przedstawiających ludzi mówiących i robiących rzeczy, których w rzeczywistości nigdy nie powiedzieli ani nie zrobili. Technologia opiera się na uczeniu głębokim, czyli rodzaju uczenia maszynowego, które polega na szkoleniu sztucznych sieci neuronowych przy dużych ilościach danych.

W 2019 roku w sieci wykryto mniej niż 15 000 deepfakes. Dziś mówimy o milionach, przy czym liczba profesjonalnie spreparowanych deepfakes nadal rośnie w zawrotnym tempie – jak podaje Światowe Forum Ekonomiczne, o 900% rocznie.

Jednym z najbardziej niepokojących aspektów deepfakes jest możliwość wykorzystania ich do złych celów, takich jak tworzenie fałszywych wiadomości lub propagandy, albo podszywanie się pod kogoś w celu osiągnięcia korzyści finansowych. Technologia ta jest również wykorzystywana do tworzenia pornografii typu deepfake, co wzbudziło obawy dotyczące możliwości nadużyć.

Ze względu na bardzo realistyczny charakter technologii deepfakes ludzie mogą uwierzyć, że widzieli coś, co w rzeczywistości nigdy się nie wydarzyło. Możliwe, że w ostateczności osoby te zapamiętają nieprawdziwy scenariusz jako fakt.

Oto kilka przykładów tego, jak deepfakes mogą przyczynić się do Efektu Mandeli i jakie niebezpieczeństwa się z nimi wiążą:

Tworzenie fake newsów

Deepfakes można wykorzystać do tworzenia fake newsów, które są tak realistyczne, że ludzie wierzą w ich autentyczność, nawet jeśli są całkowicie sfabrykowane. Idealny przykład stanowią fałszywe wiadomości o atakach terrorystycznych lub klęskach żywiołowych, które zostały stworzone wyłącznie w celu realizacji określonych programów społeczno-politycznych. Jeśli te historie są tworzone za pomocą deepfakes, mogą wyglądać jak prawdziwe doniesienia prasowe wraz z przekonującymi materiałami audio i wideo. W ostateczności może to stworzyć zniekształcony obraz historii i wydarzeń dla przyszłych pokoleń.

Kształtowanie opinii politycznej

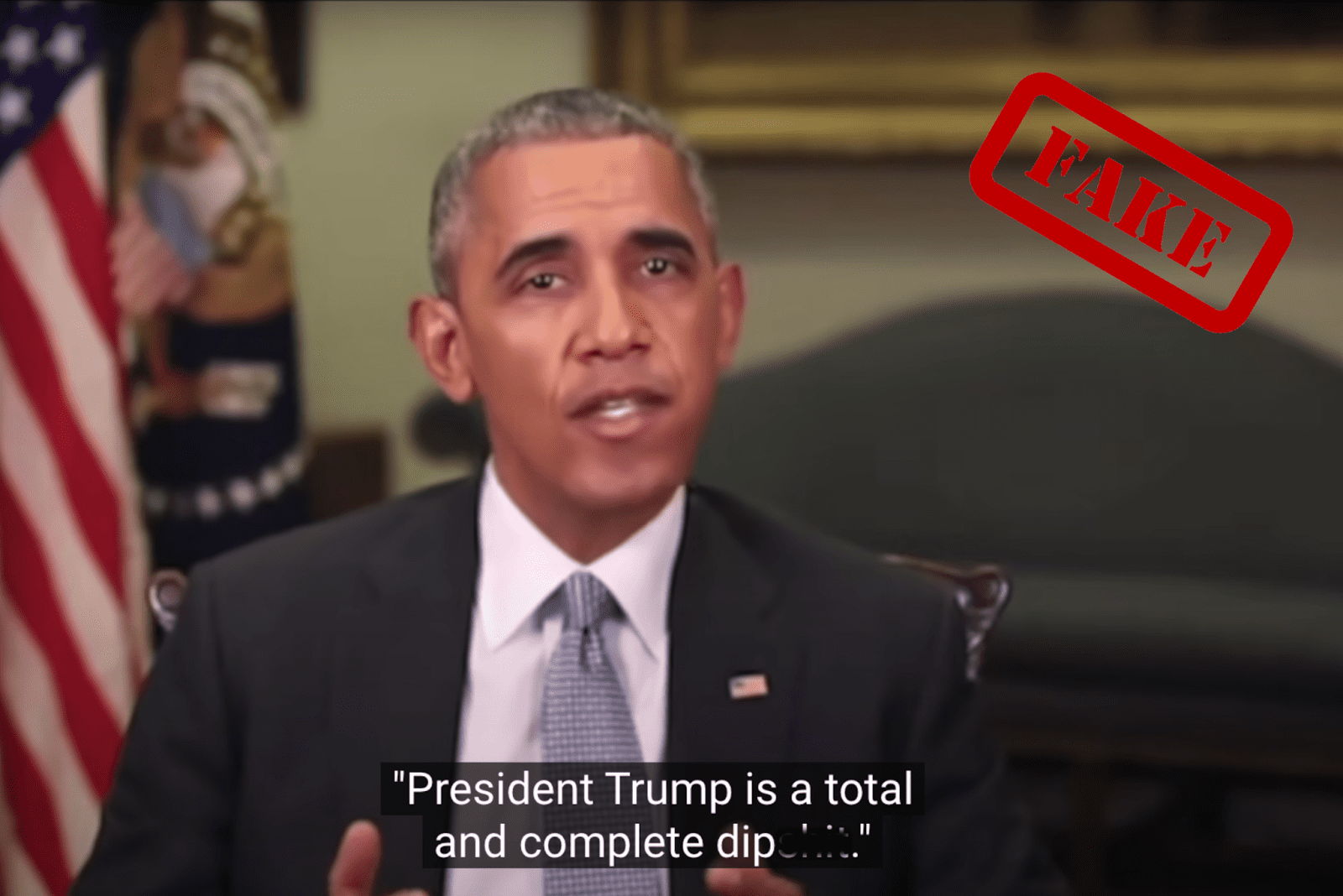

Kilka miesięcy przed wyborami w 2018 roku, do sieci trafiło deepfake'owe wideo, na którym Barack Obama obraża ówczesnego prezydenta Donalda Trumpa. Filmik został stworzony przez nagrodzonego Oscarem reżysera, Jordana Peele'a i miał na celu służyć jako ostrzeżenie, żeby nie ufać ślepo materiałom, które widzimy w sieci. Jak na ironię wielu zwolenników Trumpa uwierzyło, że wideo jest prawdziwe, po czym zaczęli wyrażać swoje oburzenie w mediach społecznościowych.

Gdyby podobne deepfake'owe wideo przedstawiające kandydata politycznego lub osobę publiczną mówiącą lub robiącą coś, co nigdy nie miało miejsca, było wystarczająco przekonujące, mogłoby mieć szkodliwy wpływ na funkcjonowanie demokracji i zaufanie ludzi do instytucji.

Na przykład, gdyby coraz więcej osób było narażonych na potencjalnie przekonujące deepfake'owe wideo z kandydatami politycznymi z ich kraju (w mediach społecznościowych lub za pośrednictwem innych kanałów informacyjnych), fałszywe wspomnienia mogłyby zostać uznane za prawdziwe. To mogłoby wpłynąć na przebieg wyborów.

Prowadzenie kampanii propagandowych

Kampanie propagandowe tworzone za pomocą deepfake'ów mogą być wykorzystywane do manipulowania opinią publiczną i rozpowszechniania dezinformacji na temat grup sponsorowanych przez państwo, co w rezultacie prowadzi do zniekształcenia obrazu rzeczywistości. Na przykład, w odniesieniu do trwającego konfliktu z Rosją, ukraiński wywiad ostrzegł niedawno, że w sieci krąży deepfake'owy filmik z prezydentem Ukrainy, Wołodymyrem Zelenskim, na którym wzywa on Ukraińców do poddania się.

Pomimo interwencji wielu platform, filmik ten nadal wyświetla się na kilku portalach społecznościowych, takich jak Facebook, Reddit i TikTok, co dzieli społeczeństwo i utrudnia ludziom rozeznanie się w prawdzie.

Przerabianie materiałów historycznych

Deepfakes mogą być wykorzystywane do modyfikacji materiałów historycznych, takich jak nagrania przemówień politycznych lub ważnych wydarzeń. To z kolei może prowadzić do nieporozumień, ponieważ ludzie nie będą pewni, co rzeczywiście wydarzyło się w przeszłości. Zmniejszy to zaufanie społeczeństwa do zapisów historycznych i mediów, a w konsekwencji przyczyni się do powstania teorii spiskowych.

Weźmy na przykład lądowanie na Księżycu. Do dziś niektórzy twierdzą, że zostało ono sfałszowane i nigdy nie miało miejsca. Deepfakes można wykorzystać do fabrykowania atrakcyjnych filmów i nagrań audio, które wzmocnią tę fałszywą narrację, tym samym zwiększając sceptycyzm i nieufność wobec autentyczności tego wydarzenia historycznego.

Manipulowanie treściami w mediach społecznościowych

Dzięki łatwemu dostępowi do platform społecznościowych deepfakes mogą być wykorzystywane do tworzenia fałszywych postów, które sprawiają wrażenie, że celebryci, osoby publiczne lub influencerzy są obecni na danym wydarzeniu lub popierają dany produkt, podczas gdy w rzeczywistości tak nie jest. Pozwalając na niekontrolowane rozprzestrzenianie się fałszywych narracji, deepfakes mogą jeszcze bardziej spolaryzować społeczeństwo i stworzyć podatny grunt dla kampanii dezinformacyjnych. To z kolei podważa wiarygodność mediów społecznościowych jako narzędzia komunikacji, co ma kluczowe znaczenie dla demokracji i spójności społecznej.

Fabrykowanie dowodów naukowych

Od powstania wirusa po przełomowe odkrycia medyczne – deepfakes mogą być wykorzystywane do tworzenia fałszywych dowodów naukowych w celu poparcia nieprawdziwych twierdzeń lub hipotez. Na przykład, niektórzy ludzie próbują szerzyć dezinformację na temat zmian klimatycznych pomimo przytłaczających dowodów naukowych, że są one spowodowane działalnością człowieka. Stanowi to zagrożenie dla ważnych kwestii, takich jak globalne ocieplenie.

Deepfakes mogą tworzyć fałszywe dowody naukowe, według których zmiana klimatu jest spowodowana czynnikami zewnętrznymi, co może mieć poważne implikacje – decydenci mogą być mniej skłonni do podejmowania działań związanych ze zmianą klimatu, jeśli pewne fakty zostaną podważone. Może to jeszcze bardziej podzielić opinię publiczną i utrudnić osiągnięcie konsensusu w sprawie sposobu rozwiązania tego ogromnego problemu.

Tworzenie fałszywych alibi

Ponadto, deepfakes mogą być również wykorzystywane do tworzenia fałszywych zeznań lub oświadczeń w sprawach sądowych lub manipulowania nagraniami z kamer bezpieczeństwa w celu stworzenia alibi dla przestępców. Może to prowadzić do tworzenia fałszywych narracji wokół wydarzeń związanych z przestępstwem, gdzie ludzie wierzą, że a) sprawca nie popełnił przestępstwa lub b) zrobiła to niewinna osoba. Z czasem ta fałszywa narracja może zakorzenić się w pamięci zbiorowej osób zaangażowanych w sprawę, a co za tym idzie, ludzie uznają ją za fakt.

Załóżmy hipotetycznie, że mamy do czynienia z dosyć głośną sprawą, gdzie obrona tworzy bardzo realistyczne nagranie typu deepfake pokazujące oskarżonego w innym miejscu w czasie popełnienia przestępstwa. Wideo jest szeroko rozpowszechniane i wiele osób stwierdza, że oskarżony nie mógł popełnić morderstwa. Nawet jeśli później okaże się, że nagranie jest fałszywe i oskarżony zostanie uznany za winnego, niektórzy ludzie pamiętający nagranie będą nadal wierzyć, że oskarżony był niewinny.

10 sposobów na wykrycie deepfake'a

Abraham Lincoln kiedyś powiedział: „Nigdy nie ufaj niczemu, co widzisz w Internecie”. No właśnie. W celu zwalczenia problemu deepfake'ów tworzących fałszywe wspomnienia, istotne jest, abyśmy wszyscy pozostali krytyczni i sceptyczni wobec informacji, które otrzymujemy, a firmy technologiczne i rząd wspólnie opracowywały rozwiązania pozwalające na wykrywanie i zapobieganie rozprzestrzenianiu się filmów typu deepfake.

W międzyczasie dowiedz się, jak rozpoznać deepfake, aby chronić się przed dezinformacją i fałszywymi wspomnieniami:

- Zniekształcona twarz i tło

- Dopatruj się zniekształceń oświetlenia i przekształceń 3D twarzy.

- Sprawdź, czy nie występują żadne niespójności w teksturze, zwłaszcza na policzkach, czole, brwiach i zaroście.

- Realistyczne ruchy oczu i ust

- Sprawdź, czy cienie, kolor oczu, ruchy pieprzyków na twarzy i mruganie wyglądają realistycznie.

- Zweryfikuj, czy usta danej osoby wyglądają naturalnie i na pewno należą do jej twarzy.

- Ruchy i gesty obiektu

- Zwróć uwagę na ruchy i gesty osoby na filmie.

- Pomyśl, czy wydają Ci się one niezręczne lub zbyt perfekcyjne.

- Analiza dźwięku

- Posłuchaj uważnie dźwięku na filmie.

- Sprawdź, czy głos brzmi sztucznie lub zawiera jakieś zniekształcenia. Pamiętaj, że głosy użyte w wideo mogą być zmienione lub wygenerowane przez AI.

- Niespójności w oświetleniu i odbiciach

- Szukaj niespójności w oświetleniu i odbiciach, które nie pasują do otoczenia lub miejscaosoby na filmie lub obrazie.

- Weryfikacja treści wideo

- Znajdź oryginalny film lub poszukaj innych przykładów, aby zweryfikować jego treść.

- Użyj odwrotnego wyszukiwania obrazów za pomocą narzędzi takich jak Google Image Search, TinEye, SauceNAO lub Bing Visual Search.

- Analiza kontekstowa

- Oceń kontekst, w jakim film został umieszczony lub udostępniony, ponieważ może on decydować o jego autentyczności (np. dlaczego papież nagle odchodzi od typowych regaliów noszonych w papieskim domu).

- Sprawdź oryginalne źródło wideo i ustal, czy jest to renomowana organizacja informacyjna, przypadkowa osoba w mediach społecznościowych, a może ktoś o niejasnych zamiarach.

- Nienaturalne lub niecodzienne sytuacje

- Miej dystans do filmów, które pokazują niecodzienne lub nieprawdopodobne sytuacje, takie jak sławna osoba robiąca coś szokującego lub polityk mówiący coś kontrowersyjnego.

- Sprawdzaj metadane

- Sprawdź metadane filmu, aby sprawdzić, czy zgadzają się z zawartymi w nim twierdzeniami, takimi jak czas i miejsce nagrania.

- Pamiętaj, że metadane mogą być łatwo zmienione, więc nie powinny stanowić jedynej podstawy do określenia autentyczności filmu.

- Bądź na bieżąco

- Miej świadomość, że technologia wykorzystywana do tworzenia deepfake'ów jest stale ulepszana i w przyszłości ich wykrycie może stać się jeszcze trudniejsze.

- Bądź na bieżąco i zachowaj ostrożność podczas udostępniania lub reagowania na filmy, które wydają się podejrzane.

Take the first step to protect yourself online. Try ExpressVPN risk-free.

Get ExpressVPN