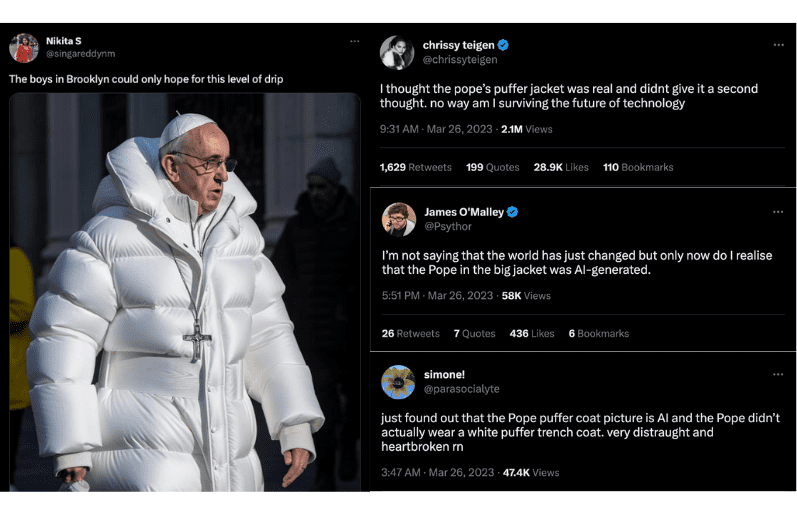

Das Internet wurde in letzter Zeit von einigen verblüffenden Bildern erschüttert. Der Papst in einer Daunenjacke und Wladimir Putin, der auf Knien die Hand von Xi Jinping küsst. Der Haken an der Sache? Keines dieser Ereignisse ist tatsächlich passiert. Sie sind das Produkt einer fortschrittlichen KI-Technologie, die als Deepfakes bezeichnet werden.

Diese auf Deep Learning basierenden Fälschungen zeigen, wie leicht KI die Grenzen zwischen Realität und Fiktion verwischen kann, mit erheblichen und weitreichenden Folgen.

[Sichern Sie Ihre Online-Aktivitäten und schützen Sie Ihre persönlichen Daten mit einer risikofreien VPN-Probeversion.]

Wir gehen der Frage nach, wie KI die Art und Weise verändert, wie wir uns an Geschehnisse erinnern, und wie Deepfakes möglicherweise zu dem als Mandela-Effekt bekannten Phänomen beitragen könnten. Machen Sie sich bereit, alles infrage zu stellen, was Sie zu wissen glaubten.

Was ist der Mandela-Effekt?

Dieser Begriff ist nach Nelson Mandela benannt, dem südafrikanischen Anti-Apartheid-Revolutionär und Politiker. Viele Menschen glaubten, er sei in den 1980er Jahren im Gefängnis gestorben, obwohl es zahlreiche Beweise gab, die das Gegenteil bezeugten. In Wirklichkeit wurde er 1990 freigelassen, zum Präsidenten des südafrikanischen Landes ernannt und verstarb schließlich im Jahr 2013.

Der Mandela-Effekt wird seither verwendet, um eine Vielzahl von falsch erinnerten Ereignissen oder Details zu beschreiben, darunter die Schreibweise von Markennamen, Liedtexte, die Handlung von Filmen oder Fernsehsendungen und die Details von historischen Ereignissen.

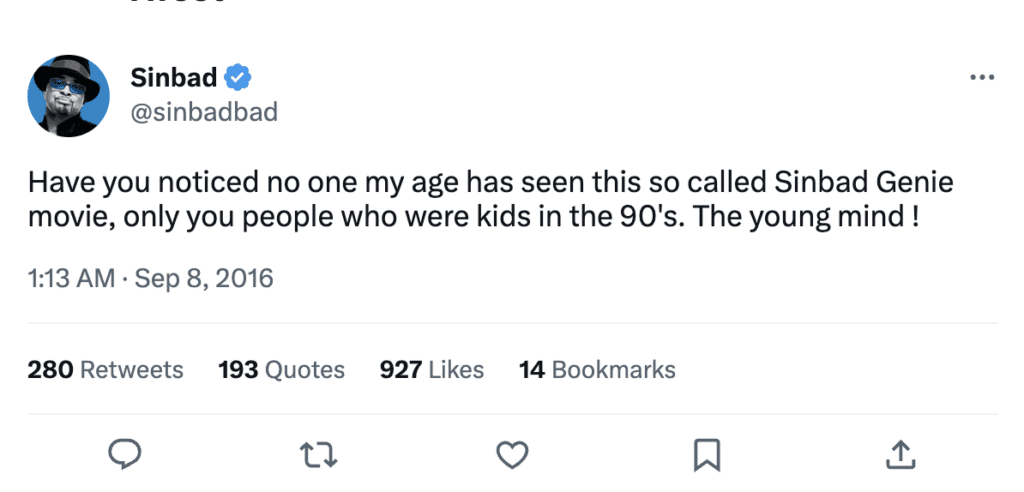

Ein Beispiel für den Mandela-Effekt in Aktion ist der beliebte Komiker Sindbad aus den 1990er Jahren. Viele Menschen behaupten, sich an einen Film namens Shazaam zu erinnern (nicht zu verwechseln mit dem Superheldenfilm Shazam! aus dem Jahr 2019), in dem Sindbad einen Flaschengeist spielt, der zwei Kindern hilft. Ein solcher Film wurde jedoch nie gedreht. Dem am nächsten kam ein Film namens Kazaam, in dem Shaquille O'Neal die Hauptrolle eines Flaschengeistes spielte.

Obwohl es keine Beweise für die Existenz von Shazaam gibt, sind viele Menschen davon überzeugt, den Film gesehen zu haben, und erinnern sich an Details über die Handlung, die Charaktere und sogar daran, wie das Filmplakat aussah. Wenngleich Sindbad selbst bestätigt hat, dass er nie einen Flaschengeist gespielt hat, hat sich die Idee des Films so sehr im Gedächtnis der Menschen verankert, dass sie sich dessen Existenz ganz sicher sind.

Spielt Ihnen Ihr Gedächtnis Streiche? Stellen Sie Ihr Wissen mit unserem Quiz zum Mandela-Effekt auf die Probe:

[evpn_typeform id="GA468t3w"]

Wie kommt es zum Mandela-Effekt?

Obwohl die Ursache des Mandela-Effekts nicht vollständig geklärt ist, gibt es mehrere Theorien, die versuchen, ihn zu erklären. Eine davon besagt, dass er auf falsche Erinnerungen zurückzuführen ist, bei denen sich Menschen aufgrund von Fehlinformationen, Fehlinterpretationen oder der Suggestivkraft an Ereignisse oder Fakten falsch erinnern. Eine andere, weitreichendere Theorie besagt, dass er auf einen Fehler in der Matrix oder ein Paralleluniversum zurückzuführen ist, in dem die Menschen eine andere Version der Realität erlebt haben könnten.

Psychologen glauben, dass der Mandela-Effekt durch die Art und Weise, wie unser Gehirn verdrahtet ist, verursacht werden könnte. Genauer gesagt, wie unser Verstand manchmal von dem beeinflusst wird, was andere Leute sagen, oder von unseren eigenen, bereits bestehenden Überzeugungen, was dazu führen kann, dass wir uns an Dinge falsch erinnern. Man spricht hier von einer kognitiven Verzerrung. Wenn zum Beispiel viele Menschen in den sozialen Medien sagen, dass etwas auf eine bestimmte Art und Weise passiert ist, kann uns das glauben machen, dass es wirklich so passiert ist, auch wenn es nicht so war.

Wenngleich der Mandela-Effekt nicht neu ist und sich hauptsächlich auf die Popkultur bezieht, geht mit dem zunehmenden Auftreten von Deepfakes einher, dass sich falsche Informationen noch schneller und einfacher verbreiten können und dass sich mehr Menschen an Dinge erinnern, die nie wirklich passiert sind.

Dies wirft wichtige Fragen darüber auf, ob wir den Informationen, die wir online sehen, vertrauen können, ob es in Ordnung ist, KI zur Manipulation von Bildern und Videos einzusetzen, und wie viel Macht die Technologie bei der Gestaltung unserer Erinnerungen und Überzeugungen haben sollte.

Die Gefahr von auf Deepfakes basierenden Erinnerungen

Deepfakes verwenden KI, um realistisch aussehende Videos und Bilder von Menschen zu erstellen, die Dinge sagen oder tun, die sie in Wirklichkeit nie gesagt oder getan haben. Die Technologie basiert auf Deep Learning, einer Art des maschinellen Lernens, bei dem künstliche neuronale Netzwerke mit großen Datenmengen trainiert werden.

Im Jahr 2019 wurden weniger als 15.000 Deepfakes im Netz registriert. Heute geht diese Zahl in die Millionen – und die Zahl der von Experten erstellten Fälschungen steigt laut The Sentinel weiterhin mit einer jährlichen Rate von 900 Prozent.

Einer der besorgniserregendsten Aspekte von Deepfakes ist ihr Potenzial, für böswillige Zwecke verwendet zu werden, wie z. B. die Erstellung von gefälschten Nachrichten oder Propaganda oder das Vortäuschen einer Person zum Zwecke des finanziellen Gewinns. Die Technologie wird auch zur Erstellung von Deepfake-Pornografie verwendet, was Bedenken hinsichtlich der Ausbeutung von Personen und des Missbrauchspotenzials aufgeworfen hat.

Deepfakes haben auch die Macht, Menschen zum Glauben zu bringen, etwas gesehen zu haben, das in Wirklichkeit nie passiert ist, da die Technologie sehr realistisch ist. Dies könnte dazu führen, dass ein unwahres Szenario als Tatsache erachtet wird.

Hier sind einige Beispiele dafür, wie Deepfakes zum Mandela-Effekt beitragen können, und welche Gefahren damit verbunden sind:

Verbreitung von Fake-News

Deepfakes könnten dazu verwendet werden, gefälschte Nachrichten zu erstellen, die so realistisch sind, dass Menschen sie für wahr halten, selbst wenn sie komplett erfunden sind. Zum Beispiel gefälschte Nachrichten über Terroranschläge oder Naturkatastrophen, die nur zu dem Zweck erstellt wurden, bestimmte gesellschaftspolitische Ziele zu erreichen. Wenn diese Geschichten mit Deepfakes erstellt werden, können sie wie echte Nachrichtenberichte aussehen und komplett mit überzeugendem Video- und Audiomaterial versehen werden. Dies könnte letztlich ein verzerrtes Bild der Geschichte und der Ereignisse für kommende Generationen schaffen.

Beeinflussung der politischen Meinung

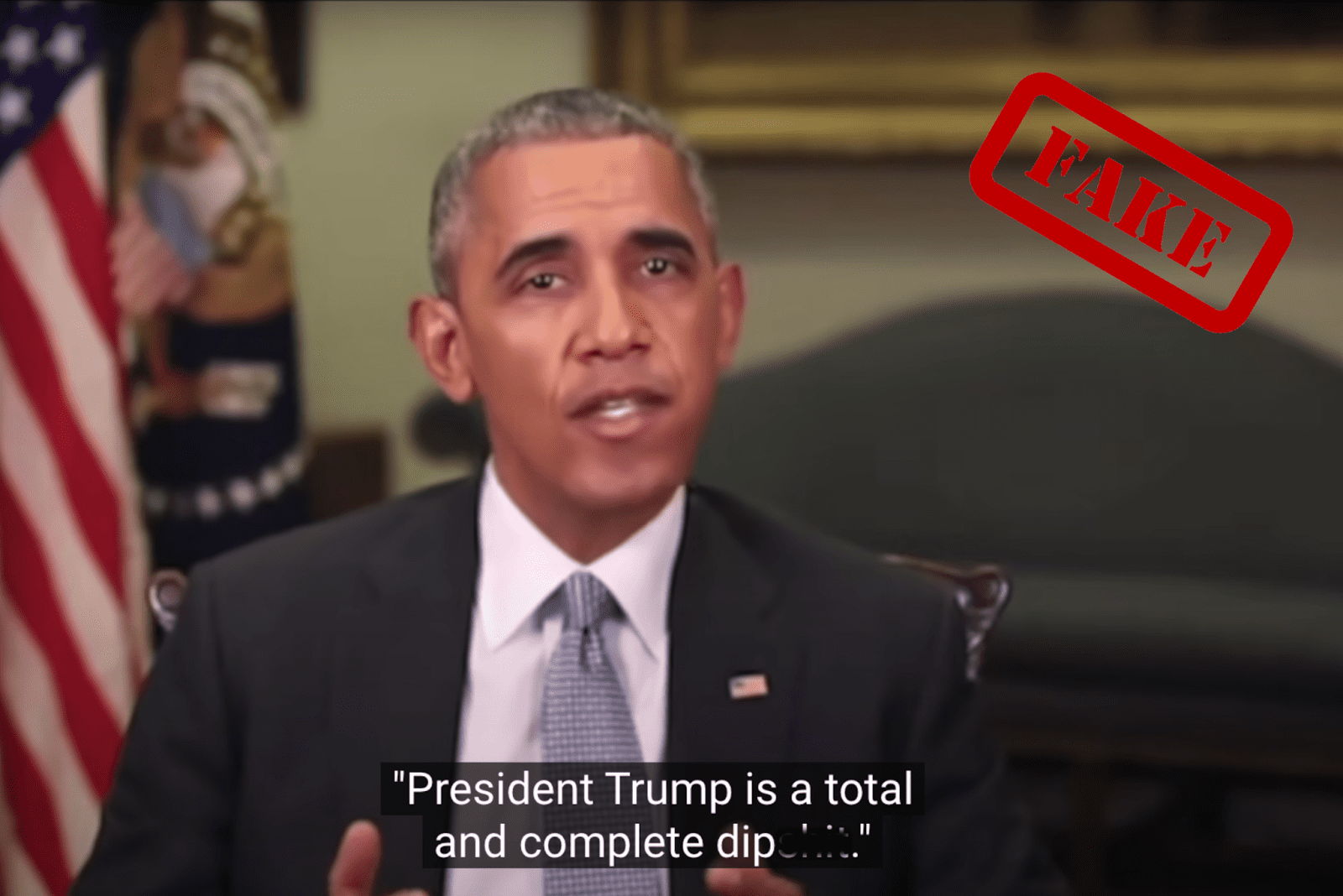

Einige Monate vor den US-Zwischenwahlen 2018 ging ein gefälschtes Video von Barack Obama, in dem er den damaligen Präsidenten Donald Trump beschimpft, viral. Es war von Oscar-Preisträger und Regisseur Jordan Peele erstellt worden, um die Nutzer davor zu warnen, dem im Internet kursierenden Material zu vertrauen. Ironischerweise ging das Video-Beispiel nach hinten los, nachdem viele von Trumps Anhängern geglaubt hatten, es sei echt, und Horden von ihnen in den sozialen Medien ihre Empörung zum Ausdruck brachten.

Wenn ein ähnliches Deepfake-Video, in dem ein politischer Kandidat oder eine Person des öffentlichen Lebens etwas sagt oder tut, was in Wirklichkeit nie passiert ist, überzeugend genug wäre, könnte es sich nachteilig auf die Demokratie und das Vertrauen der Menschen in die Institutionen auswirken.

Wenn zum Beispiel immer mehr Menschen ein potenziell überzeugendes Deepfake-Video der politischen Kandidaten ihres Landes in den sozialen Medien oder über verschiedene Nachrichtenkanäle sehen, könnten sich falsche Erinnerungen verbreiten und als wahr hingenommen werden. Dies kann beeinflussen, wen die Menschen bei Wahlen wählen und wen sie zu ihren Anführern ernennen.

Unterstützung von Propaganda-Kampagnen

Mit Deepfakes erstellte Propaganda-Kampagnen können dazu verwendet werden, die öffentliche Meinung zu manipulieren und Desinformationen über staatlich geförderte Gruppen zu verbreiten – was letztlich zu einer verzerrten Sicht der Realität führt. So warnte der ukrainische Geheimdienst vor kurzem im Zusammenhang mit dem anhaltenden Konflikt mit Russland davor, dass ein Deepfake des ukrainischen Präsidenten Wolodymyr Selenskyj in Umlauf gebracht wurde, auf dem er zu sehen ist, wie er die Ukrainer auffordert, sich zu ergeben.

Obwohl viele Plattformen das Video vom Netz genommen haben, taucht es weiterhin auf verschiedenen Social-Media-Websites wie Facebook, Reddit und TikTok auf – und sorgt so für Zwietracht in der Öffentlichkeit und erschwert es ihr, die Wahrheit zu erkennen.

Veränderung von historischem Filmmaterial

Deepfakes könnten dazu verwendet werden, historisches Filmmaterial, wie z. B. Aufnahmen von politischen Reden oder wichtigen Ereignissen, so zu verändern, dass sich die Menschen nicht mehr an das erinnern, was tatsächlich passiert ist. Dies könnte zu Verwirrung und Ungewissheit darüber führen, was sich in der Vergangenheit tatsächlich zugetragen hat, und das Vertrauen der Öffentlichkeit in historische Aufzeichnungen und Medien untergraben – was letztlich Verschwörungstheorien hervorruft.

Nehmen Sie zum Beispiel die Mondlandung. Bis heute behaupten manche, dass es sich um eine Fälschung handelte und die Mondlandung nie wirklich stattgefunden hat. Deepfakes könnten genutzt werden, um überzeugende Videos und Audioaufnahmen zu fabrizieren, die dieses falsche Narrativ untermauern und die Skepsis und das Misstrauen in die Echtheit des historischen Ereignisses verstärken.

Manipulation von Social-Media-Inhalten

Durch den leichten Zugang zu Social Media-Plattformen können Deepfakes dazu verwendet werden, gefälschte Beiträge zu erstellen, die den Anschein erwecken, dass Prominente, Persönlichkeiten des öffentlichen Lebens oder Influencer bei einer Veranstaltung anwesend sind oder ein bestimmtes Produkt befürworten, obwohl das nicht der Wirklichkeit entspricht. Indem sie es ermöglichen, falsche Darstellungen unkontrolliert zu verbreiten, können Deepfakes die Gesellschaft weiter polarisieren und einen fruchtbaren Boden für Desinformationskampagnen schaffen. Dies wiederum untergräbt die Glaubwürdigkeit der sozialen Medien als Kommunikationsmittel, das für die Demokratie und den sozialen Zusammenhalt entscheidend ist.

Fälschung wissenschaftlicher Beweise

Vom Ursprung eines Virus bis hin zu medizinischen Durchbrüchen können Deepfakes verwendet werden, um gefälschte wissenschaftliche Beweise zur Unterstützung einer unwahren Behauptung oder Hypothese zu erstellen. Einige Leute versuchen zum Beispiel, Desinformationen über den Klimawandel zu verbreiten, obwohl es überwältigende wissenschaftliche Beweise dafür gibt, dass der Klimawandel durch menschliche Aktivitäten verursacht wird. Dies stellt eine Bedrohung für wichtige Themen wie die globale Erwärmung dar.

Deepfakes können falsche wissenschaftliche Beweise liefern, die behaupten, dass der Klimawandel durch externe Faktoren verursacht wird. Das kann schwerwiegende Folgen haben: Politische Entscheidungsträger sind möglicherweise weniger geneigt, Maßnahmen zur Bekämpfung des Klimawandels zu ergreifen, wenn eine weit verbreitete Skepsis hinsichtlich der Ursachen besteht. Dies könnte die öffentliche Meinung weiter spalten und es schwieriger machen, einen Konsens darüber zu finden, wie dieses dringende Problem angegangen werden soll.

Schaffung falscher Alibis

Darüber hinaus könnten Deepfakes auch verwendet werden, um falsche Geständnisse oder Aussagen in Gerichtsverfahren zu erstellen oder um Sicherheitsaufnahmen zu manipulieren und dadurch Alibis für Kriminelle zu schaffen. Dies könnte dazu führen, dass falsche Berichterstattungen zu den Ereignissen des Verbrechens entstehen und die Menschen glauben, dass a) der Täter das Verbrechen nicht begangen hat oder b) dass eine unschuldige Person es getan hat. Mit der Zeit könnte sich diese falsche Erzählung im kollektiven Gedächtnis der an dem Fall Beteiligten festsetzen, sodass sie sie für eine Tatsache halten.

Nehmen wir an, es gibt einen hochkarätigen Strafprozess, bei dem das Verteidigungsteam ein äußerst realistisches Deepfake-Video erstellt, das den Angeklagten zur Tatzeit an einem anderen Ort zeigt. Das Video wird weit verbreitet und viele Menschen kommen zu der Überzeugung, dass der Angeklagte den Mord nicht begangen haben kann. Selbst wenn sich das Video später als Deepfake herausstellt und der Angeklagte für schuldig befunden wird, glauben manche Menschen aufgrund ihrer Erinnerung an das Video weiterhin, dass der Angeklagte unschuldig war.

10 Wege, einen Deepfake zu erkennen

Um es mit den weisen Worten von Abraham Lincoln zu sagen: "Traue nie etwas, was du im Internet siehst." Um das Problem der Deepfakes, die falsche Erinnerungen erzeugen, zu bekämpfen, müssen wir alle kritisch und skeptisch gegenüber den Informationen bleiben, die wir konsumieren, und Technologieunternehmen und Regierungen müssen zusammenarbeiten, um Lösungen zu entwickeln, die die Verbreitung von Deepfake-Videos erkennen und verhindern.

In der Zwischenzeit sollten Sie lernen, wie Sie einen Deepfake erkennen, um sich vor der Verbreitung von Fehlinformationen und falschen Erinnerungen zu schützen:

- Unstimmigkeiten und Verformungen der Gesichter

- Achten Sie auf Verzerrungen bei der Beleuchtung und 3D-Konvertierung im Gesicht.

- Prüfen Sie das Bild auf Unstimmigkeiten in der Textur, insbesondere bei Wangen, Stirn, Augenbrauen und Gesichtsbehaarung.

- Realistische Augen- und Lippenbewegungen

- Prüfen Sie, ob die Schattierung, die Augenfarbe und die Bewegungen von Gesichtsmalen und das Blinzeln realistisch aussehen.

- Prüfen Sie, ob die Lippen der Person natürlich aussehen und zu diesem Gesicht gehören.

- Bewegungen und Gesten der Person

- Achten Sie auf die Bewegungen und Gesten der Person im Video.

- Prüfen Sie, ob diese ungeschickt oder zu perfekt wirken.

- Audio-Analyse

- Hören Sie sich den Ton im Video genau an.

- Prüfen Sie, ob die Stimme künstlich klingt oder Verzerrungen aufweist, da möglicherweise KI-generierte oder veränderte Stimmen verwendet werden.

- Unstimmigkeiten bei der Beleuchtung und Reflexionen

- Achten Sie auf Ungereimtheiten bei der Beleuchtung und auf Reflexionen, die möglicherweise nicht zur Umgebung oder zur Position der Person im Video oder Bild passen.

- Verifizieren Sie den Videoinhalt

- Suchen Sie nach dem Originalvideo oder suchen Sie nach anderen Beispielen des Videos, um den Inhalt zu überprüfen.

- Verwenden Sie die umgekehrte Bildsuche mit Tools wie Google Image Search, TinEye, SauceNAO oder Bing Visual Search.

- Analysieren Sie den Zusammenhang

- Prüfen Sie den Kontext, in dem das Video gepostet oder geteilt wurde, da dies ein Hinweis darauf sein kann, ob es echt ist oder nicht (z. B. warum würde der Papst plötzlich von den typischen Insignien abweichen, die im päpstlichen Haushalt oft getragen werden).

- Überprüfen Sie, ob es sich bei der ursprünglichen Quelle des Videos um eine seriöse Nachrichtenorganisation, eine unbekannte Person in den sozialen Medien oder eine Person mit einer fragwürdigen Agenda handelt.

- Unnatürliche oder unübliche Situationen

- Seien Sie skeptisch bei Videos, die ungewöhnliche oder unwahrscheinliche Situationen zeigen, wie z. B. eine berühmte Person, die etwas Ungewöhnliches tut oder eine politische Figur, die etwas Kontroverses sagt.

- Prüfen Sie die Metadaten

- Überprüfen Sie die Metadaten des Videos, um zu sehen, ob sie mit den im Video gemachten Angaben übereinstimmen, z. B. Zeit und Ort der Aufnahme.

- Denken Sie daran, dass Metadaten leicht verändert werden können. Sie sollten daher nicht die einzige Grundlage für die Feststellung der Authentizität eines Videos sein.

- Bleiben Sie auf dem Laufenden

- Seien Sie sich bewusst, dass die Technologie zur Erstellung von Deepfakes ständig verbessert wird und dass es in Zukunft schwieriger werden könnte, sie zu erkennen.

- Halten Sie sich so gut wie möglich über neue Entwicklungen in diesem Bereich auf dem Laufenden und seien Sie vorsichtig, wenn Sie Videos, die verdächtig oder extrem berichtenswert erscheinen, teilen.

Take the first step to protect yourself online. Try ExpressVPN risk-free.

Get ExpressVPN